Hive on Spark: Getting Started里面介绍了如果Hive的查询引擎选择Spark的话,Hive所需相关配置。如果用一个不兼容的Hive和Spark版本,有潜在风险,例如Spark2就没有spark-assembly-*.jar可供低版本Hive使用。 问题来了,么查找已测试的Hive和Spark版本对呢? 网上有人说看Hive代码根路径下的pom.xml。例如Hive branch-1.2中pom.xml包含spark.version为1.3.1,这说明官方在进行Hive1.2.0测试时用的Spark 1.3.1。 此外,也可借鉴C家、H家和MapR技术栈的版本搭配:

- CDH 5 Packaging and Tarball Information中列出了CHD5中技术栈的版本情况。

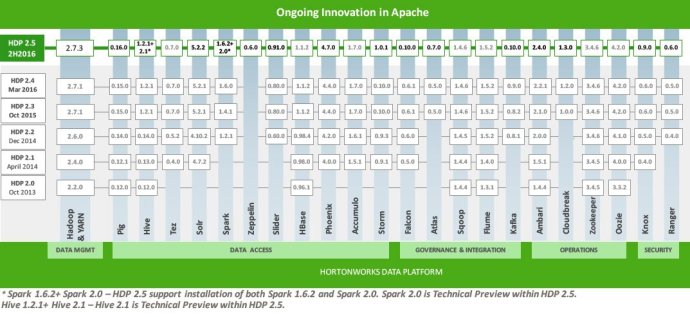

- 在Hortonworks Data Platform列出了HDP所用的技术栈的版本情况。

- MapR Ecosystem Support Matrix中列出了MapR中技术栈的版本情况。